Proteinstrukturen aus der Wolke

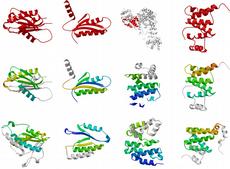

ETH-Forscher haben in einer Zusammenarbeit mit IBM einen neuen Weg getestet, um riesige Datenmengen rechnen zu lassen: Statt zentraler Supercomputer nutzen sie «Cloud Computing», um dreidimensionale Proteinstrukturen zu berechnen.

In Zellen werden Aminosäure-Bausteine zu Ketten – den Proteinen - verschiedener Länge aneinandergereiht. Die allermeisten dieser Aminosäuren-Ketten falten sich unmittelbar nach ihrer Synthese zu oft komplizierten dreidimensionalen Strukturen.

Die Forschung möchte nicht nur wissen, welche Aminosäuren in welcher Abfolge das Protein bilden, sondern wie Eiweisse «wirklich» aussehen. Dazu füttern die Biologen Computer mit Daten, zum Beispiel mit Daten aus massenspektrometrischen Messungen von Proteinen. Der Computer berechnet schliesslich mittels spezieller Software unzählige Strukturvarianten. Um diese riesigen Datensätze zu verarbeiten, braucht es dazu die Rechenpower von Supercomputern - bisher.

Millionen von Varianten

Lars Malmström und Ruedi Aebersold, Professor am Institut für molekulare Systembiologie, haben nun im Rahmen eines SystemsX-Projekts einen neuen Ansatz gewählt, um die Strukturen von 249 Proteinen des Bakteriums Streptococcus zu berechnen: Sie schickten ihre Daten «in die Wolke», einem virtuellen Grosscomputer, der auf zahlreiche verschiedene Maschinen verteilt war. Malmström liess auf diese Weise von jedem der fraglichen Proteine 10'000 Varianten berechnen, insgesamt 2,3 Millionen verschiedene Proteinmodelle, und das innerhalb von zwei Wochen. Ohne Cloud Computing hätte dieses Experiment mehrere Monate gedauert.

Das Experiment wurde auf einer sogenannten «Shared Private Cloud» auf Servern des IBM Cloud Datacenter in Toronto durchgeführt. Für diesen Versuch stellte IBM insgesamt 1000 virtuelle CPUs parallel zur Verfügung. Die Rechenkapazität der Cloud entsprach damit ungefähr derjenigen von rund 1000 parallel rechnenden privaten Laptops, was den Systembiologen 250'000 Rechnerstunden pro CPU ermöglichte. Die Anzahl physischer Server, die zur Rechenleistung in der Cloud beigetragen haben, kann nicht genau angegeben werden. Die Forscher nutzten indes nur einen Teil des Datacenters, das noch wesentlich höhere Kapazitäten zur Verfügung stellen kann. Für Datenmengen gebe es kaum obere Grenzen, sagt der Pressesprecher von IBM, Sebastian Drews. Limitierende Faktoren seien die Auslastung des Data Center in einer «geteilten» Umgebung, die Kapazität der Datenleitungen oder der angestrebte Zeitrahmen, in dem die Berechnungen stattfinden sollen.

Cloud Broker installiert Software

Für die Berechnung und Visualisierung der dreidimensionalen Proteinstrukturen brauchte es die Open-Source-Software «Rosetta». Diese wurde von der Firma CloudBroker, einem ETH Spin-off, optimal eingerichtet, sodass sie allen Maschinen in der Wolke verfügbar war. Die Forscher mussten schliesslich via CloudBroker nur noch die Daten hochladen und erhielten innerhalb nützlicher Frist die Resultate zurück.

Dieses Vorgehen hat für die Forscher mehrere Vorteile. Sie müssen sich nicht mit komplizierter Software befassen. Ausserdem ist es aufwändig und schwierig, auf Grossrechnern, wie dem ETH-eigenen Cluster BRUTUS, entsprechende Programme aufzuspielen und zu benutzen. Zudem ist es aufwändig, Rechenzeit an einem Supercomputer zu erhalten. Um Rechenzeit in der Wolke zu erhalten, genügt ein unkompliziertes Aufnahmeverfahren.

Erschwingliche Alternative

«Die Verwendung einer Cloud für Struktur-Berechnungen von Proteinen ist sehr kosteneffizient», sagt Aebersold. Die Forscher bezahlen nur nach Auftrag, allenfalls für bestimmte Software. Die Wartung, Stromkosten, Neuanschaffung und das Aufsetzen von Grossrechnern entfallen, beziehungsweise, sie sind im Preis eingerechnet und werden demnach über viele Projekte verteilt. Damit wird Cloud Supercomputing gerade für kleinere Universitäten erschwinglich. Ein weiterer Vorteil: Um mit Cloud Computing zu arbeiten, seien nur moderate IT-Kenntnisse nötig, sagt Aebersold. «Selbst ein Student ist in der Lage, dieses Werkzeug effektiv einzusetzen.»

Die beiden Forscher sind deshalb überzeugt, dass Cloud Computing die Wissenschaften beschleunigen wird, die auf viel Rechenpower angewiesen sind, wie zum Beispiel die Systembiologie. Und umgekehrt. Die Systembiologie mit ihren riesigen Datensätzen, die es zu berechnen gilt, gehört ihrerseits zu den treibenden Kräften von neuen Lösungen bei Rechnerkapazität und der Speicherung der generierten Daten.

Punkto Datensicherheit haben Aebersold und Malmström wenig Bedenken. «Keines der von uns gerechneten Proteine wird zu einem millionenschweren Medikament», sagt der ETH-Professor. Eine Chiffriertechnik anzuwenden würde das Projekt unnötig verteuern. «Die Wolke ist sicher», sagt Malmström.

Richtige Struktur aus Heuhaufen suchen

Mit der Berechnung dieser Strukturvarianten ist die Arbeit der Forscher jedoch längst nicht beendet. Aus all den vielen Möglichkeiten müssen sie nun diejenigen finden, die am wahrscheinlichsten sind und in Natura vorkommen dürften. Auch dabei wird ihnen der Computer zu Hilfe kommen.

Sind die richtigen Strukturen erst einmal bestimmt, möchte sich Aebersold auch an Proteinkomplexen versuchen, um herauszufinden, welche Proteine sich wie und wo miteinander verbinden. «Die Frage ist, an welchen Stellen berühren sich Proteine, wo kommen Interaktionen vor.» Da gebe es nur schon bei Komplexen von wenigen Proteinen Millionen von Möglichkeiten. Nicht zu reden von Proteinnetzwerken in Zellen, deren Aufklärung das erklärte Ziel der Systembiologie ist.

LESERKOMMENTARE