Interdisziplinärer Blick ins Erdinnere

Die Schweizerischen Plattform für High-Performance and High-Productivity Computing (HP2C) ist ein weltweit einzigartiges Projekt mit dem Ziel, für Hochleistungsrechner optimierte wissenschaftliche Simulationen zu entwickeln. Mit dabei sind auch Seismologen der ETH-Zürich. Sie sind beteiligt am Projekt «Petaquake».

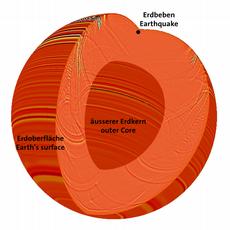

Wie ist das Erdinnere genau aufgebaut? Welche Prozesse spielen sich darin ab und wie genau entstehen Erdbeben? Das sind einige der zentralen Fragen zu unserem Globus, die bis anhin nicht eindeutig geklärt sind. Ein Blick in das Erdinnere analog einer Computertomographie beim Menschen könnte die Antworten liefern und somit die Erdbeben-Gefahrenkarten verbessern helfen. Eine wichtige Grundlage beispielsweise für die Gefahreneinschätzung der Standorte von Schweizer Kernkraftwerken oder Krankenhäusern.

Tomographische Aufnahme

Die heutigen Supercomputer sind zwar bereits in der Lage, eine Billiarde Rechenschritte pro Sekunde durchzuführen, aber die Rechner und Programme zur Modellierung sind zu wenig aufeinander abgestimmt, um hochauflösende komplexe Bilder vom Erdinnern in einer vernünftigen Zeit zu berechnen. Die Erde zu durchleuchten ist im Vergleich zum Menschen ein schwieriges Unterfangen, da Erdbeben sowie Seismographen unregelmässig auftreten, beziehungsweise an der Oberfläche verteilt sind. Zudem durchdringen seismische Wellen im Gegensatz zu den Röntgenstrahlen bei der Computertomographie grosse Teile des Erdinneren nicht. Das Projekt «Petaquake», für das sich Wissenschaftler des Instituts für Geophysik der ETH Zürich unter Leitung des ETH-Professors Domenico Giardini sowie Mathematiker und Informatiker der Uni Basel unter Leitung der Professoren Helmar Burkhart und Marcus Grote sowie PD Olaf Schenk, zusammengeschlossen haben, könnte dereinst aber einen ähnlichen Einblick in die Erde wie in den Menschen gewähren.

«Petaquake» ist eines der vielversprechenden Projekte der im Jahr 2009 lancierten Schweizerischen Plattform für High-Performance and High-Productivity Computing (HP2C). Ziel der HP2C-Plattform ist es, durch die interdisziplinäre Zusammenarbeit von Hardware-Herstellern, Informatikern, Mathematikern und Benutzern bereits bis zum Jahr 2013 spezielle Methoden und Algorithmen für Hochleistungsrechner zu entwickeln, so dass zukünftig komplexe Simulationen nicht Monate oder gar Jahre dauern, sondern nur wenige Stunden.

Das Erdinnere sichtbar machen

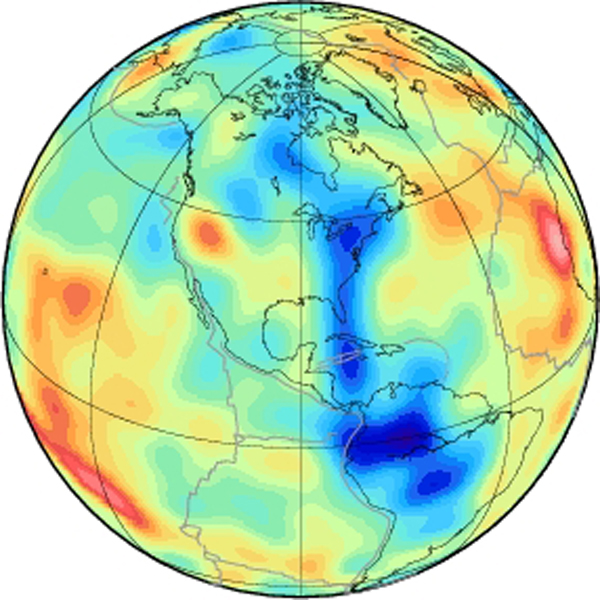

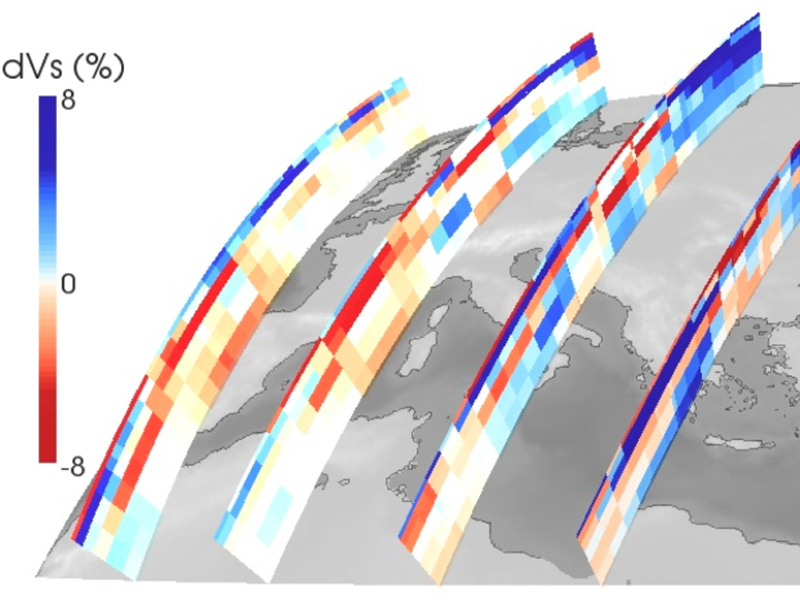

Von einem Erdbeben ausgelöste seismische Wellen durchlaufen die Erde abhängig vom Material, das sie durchdringen, mit unterschiedlichen Geschwindigkeiten. Das Wissen, wie das Erdinnere aufgebaut ist, basiert vor allem auf der Modellierung dieser seismischer Wellen, bei der bestimmte Annahmen über das Erdinnere getroffen werden. «Mit der Vorstellung, dass sich seismische Wellen wie optische Wellen verhalten, haben wir viele Erkenntnisse gewonnen», sagt Lapo Boschi, Oberassistent bei Giardini. Dies sei aber nur eine Annäherung an die Realität. Das Ziel von «Petaquake» ist für die Wissenschaftler nun hochauflösende tomographische Bilder von Prozessen im Zehner-Kilometer-Bereich zu errechnen. Solche Bilder durch verbesserte Algorithmen, die unter anderem die Wellenphysik hinreichend berücksichtigen, zu erhalten, ist für Boschi das Spannendste an dem Projekt.

Die Gruppe Giardinis, zu der auch die beiden Oberassistenten Tarje Nissen-Meyer und Luis Dalguer gehören, entwickelte zusammen mit den Mathematikern und Informatikern numerische Verfahren, die sowohl die Ausbreitung der seismischen Wellen (Vorwärtsproblemlösung) als auch neue tomographische Modelle anhand realer seismischer Daten (Inversionsproblemlösung) beschreiben. «Die Berücksichtigung des Wellencharakters, die Auflösung relevanter geophysikalischer Prozesse mit Hilfe von Supercomputern sowie die Flut an hochwertigen neuen Daten prägen eine spannende Phase der modernen Seismologie», sagt Nissen-Meyer. Er möchte mit Hilfe der neuen Modelle unter anderem die Dynamik des Erdmantels sowie das Erdmagnetfeld untersuchen.

Sicherheit von KKW-Standorten

Zum Einsatz kommen die neuen Algorithmen zudem für die Erdbebenforschung, insbesondere zur Gefahreneinschätzung. Anhand der neuen Modelle erforscht Luis Dalguer die Dynamik und das Verhalten der Bruchzonen, an denen Erdbeben entstehen. «Petaquake» soll beispielsweise über eine lokale und kleinräumige dreidimensionale Auflösung ermöglichen, detailliert zu zeigen, wie sich Bruchzonen entwickeln, wo sie initiiert werden, warum und wann sie enden. Die Ergebnisse sollen dazu beitragen die Bodenerschütterungen zu modellieren, die durch ein Beben verursacht werden. Dies ist laut den Forschern relevant für die Beurteilung der Sicherheit von KKW-Standorten.

Seit die Auswertungen der «Probabilistische Erdbebengefährdungsanalyse für KKW-Standorte in der Schweiz», kurz «Projekt Pegasos», im Jahr 2007 der Öffentlichkeit vorgestellt wurden, wurde nämlich deutlich, dass die Erdbebengefährdung der Schweizer Kernkraftwerke unterschätzt worden sein könnte. Die Beurteilung basiert auf ausführlichen weltweiten Messreihen seit den 1980er Jahren. Diese zeigen, dass Erdbebenerschütterungen auch in Gebieten, in denen mässig grosse Beben erwartet werden, stärker sein könnten als zuvor angenommen. Neue Methoden für die Gefahreneinschätzung legen deshalb nun den Fokus auf die Beschaffenheit des Untergrunds, durch den sich die seismischen Wellen ausbreiten: Starke Bodenerschütterungen nahe der Bruchzone werden simuliert, um Unsicherheiten in der Einschätzungen zu reduzieren.

Für die Seismologen eröffneten Supercomputer bereits vor rund zwanzig Jahren eine neue Generation der Erdbebenforschung. «Mit den 3D-Modellen können wir sogar die Mechanik und Physik sichtbar machen, die hinter der Ausbreitung der Bruchzonen steht», sagt Dalguer.

Schlüsselkomponenten zum Erfolg

Grote und Schenk liefern im Projekt die Hardware-nahen Algorithmen, die dem Rechner den Programmablauf vorgeben, um eine möglichst realitätsnahe Simulation zu generieren. Die mathematische Modellierung ist die «Sprache», in der alle Beteiligten formal kommunizieren. Eine Sprache, welche die gesamte Physik einer elastischen Wellengleichung abdeckt. Um ein realistisches Bild zu erhalten, teilen die Wissenschaftler die Erde mit einem flexiblen Gitter ein. Unterschiedlich grosse Tetraeder ermöglichen die räumliche, zeitabhängige Ausbreitung der Wellen in definierten Abständen voneinander darzustellen. Zudem mussten sie ein Verfahren entwickeln, das erlaubt, die Zeitschritte, während der sich die Wellen durch einen bestimmten Bereich bewegen, in benachbarten verschieden grossen Tetraedern unterschiedlich zu wählen. Beide Verfahren sind für Grote die Schlüsselkomponenten zum Erfolg des Projekts. «Diese Bestandteile gilt es nun so zu optimieren, dass sie innert kurzer Zeit die Welle simulieren und dabei die seismische Wellengleichung exakt erfüllen», sagt Schenk. Passen die simulierte Welle und die vom Seismometer aufgezeichneten Daten zusammen, kann das durchdrungene Medium beschrieben und das Erdinnere in einem neuen dreidimensionalen Modell dargestellt werden.

Für Grote ist das Projekt ein Katalysator: «Normalerweise dauert es bis zu zehn Jahre, von der Vorstellung eines neuen Algorithmus auf einer Konferenz über dessen Publikation bis ihn beispielsweise Seismologen schliesslich anwenden.» Grote und Schenk sind spezialisiert auf numerische Verfahren zur Simulation von Wellenphänomenen mit Hochleistungsrechnern, die sich nicht nur in der Seismik, sondern beispielsweise auch in der Medizin bei bildgebenden Verfahren anwenden lassen.

HP2C regt bereits zum Nachahmen an

Treibende Kraft hinter HP2C ist der

ETH-Professor und Direktor des Nationalen Rechenzentrums der Schweiz (CSCS)

Thomas Schulthess. Zusammen mit Piero Martinoli, dem Präsidenten der Università della Svizzera italiana (USI), initiierte

Schulthess HP2C. Der Erfolg der HP2C-Plattform wird sich laut Schulthess

spätestens in drei Jahren zeigen. Er sieht in dem Projekt viele Chancen, aber

auch Herausforderungen - letztere vor allem darin, die Programme auf den

Rechnern zum Laufen zu bringen. Die Zusammenarbeit mit der Industrie - die ihrerseits

grosses Interesse an dem HP2C-Projekt bekundet hat – ist für die

Wissenschaftler essentiell. Wenn die wissenschaftlichen und mathematischen

Fragestellungen gut formuliert sind, können die Computer entsprechend optimiert

werden, sagt Schulthess. Für ihn ist nicht wichtig, den schnellsten Rechner in

der Schweiz zu haben, sondern ihm ist klar: «Durch das Netzwerk der

HP2C-Plattform werden das CSCS und die Schweiz ein Know-how entwickeln, das

weltweit einzigartig sein wird.» Bereits jetzt hat das Projekt die

Aufmerksamkeit der grössten Industrienationen der Welt, der G8-Staaten, geweckt

und diese zu einem Nachahmer-Projekt angeregt.

Zum Projekt

Thomas Schulthess formulierte 2008 ein

Projekt für die Rektorenkonferenz der Schweizer Universitäten (CRUS), mit dem

die Zusammenarbeit des CSCS mit der USI gestärkt und Grundprobleme im

Supercomputing strukturiert angegangen werden sollten. Ursprünglich war das HP2C-Projekt kleiner geplant und auf etwa 4 Millionen

Franken angelegt. Die Schweizerischen Universitätenkonferenz regte an, die

Plattform schweizweit zu erweitern und steuert heute zu dem Projekt etwa 80

Prozent der Finanzierung, rund 14,5 Millionen Franken, bei. HP2C ist ein

zentrales Element der vom Bund seit 2009 geförderten nationalen Strategie für

Hochleistungsrechnen und ein weltweit einzigartiges Netzwerk, indem

verschiedenen Interessensgruppen interdisziplinär miteinander zusammenarbeiten.

Trotz der hohen Anforderungen, die der

«Call for Proposals» an die Projekte stellte, gingen 17 Projektentwürfe ein.

Acht Projekte aus den Bereichen Fluid- und Molekulardynamik, Astronomie,

Mathematik, Informatik, Medizin, Biologie, so wie Seismologie hielten dem an

der USI durchgeführten Review-Prozess von internationalen Begutachtern stand

und schafften es auf Anhieb durch das Review-Verfahren, drei weitere folgten

nach Überarbeitung der Anträge.

Das CSCS liefert im

Projekt das Know-how im Bereich der Computerwissenschaften, die USI im Bereich

der angewandten Mathematik. Zudem entwickelt das CSCS in Zusammenarbeit mit der

Industrie neue Computerarchitekturen und die Softwareumgebung auf massiv

parallelen Rechnerarchitekturen.

LESERKOMMENTARE